近年ではChatGPTをビジネスシーンで活用するケースが増えてきました。実際に業務で活用している人も多いでしょう。

しかし、

- ChatGPTの安全性はどの程度のものか

- 自動学習機能により、情報漏洩する可能性があるのでは

- アウトプットの内容は著作権法などに配慮しているのか

このような不安を持っている人も多いでしょう。ChatGPTはすぐれたAIツールではありOpenAIが開発していることから、安全性に関しては一定以上確保されていると言えます。

しかしあらゆるサービスと同様、常に完璧なセキュリティが保たれているわけではありません。そこで本記事では、ChatGPT利用時に考えられるリスクや、安全性を高める工夫に関して解説します。

特に企業単位での利用を考えている担当者の方はぜひ参考にしてください。

ChatGPTの安全性は完全ではない|起因するリスクを解説

ChatGPTの安全性が完全でないことに起因するリスクとして、以下が挙げられます。

- 情報漏洩

- サイバー犯罪の悪用

- 悪意あるコーディング生成

- 誤った情報の発信

- 倫理的に問題ある情報の発信

- 著作権法違反

主だった部分に限定してもこれだけの危険性が考えられます。個人であれば影響は小さいと考えられますが、企業が活用する場合、これらのリスクは無視しがたいものです。それぞれ詳しく解説するので参考にしてください。

情報漏洩|企業の機密情報が何らかの形で流出する

もっとも懸念される事態のひとつとして、情報漏洩が考えられます。

まず、テキストベースで機密情報を入力した場合、それが流出するかもしれません。AIが自動学習し、誤って別のユーザーにアウトプットとして提供する可能性があります。

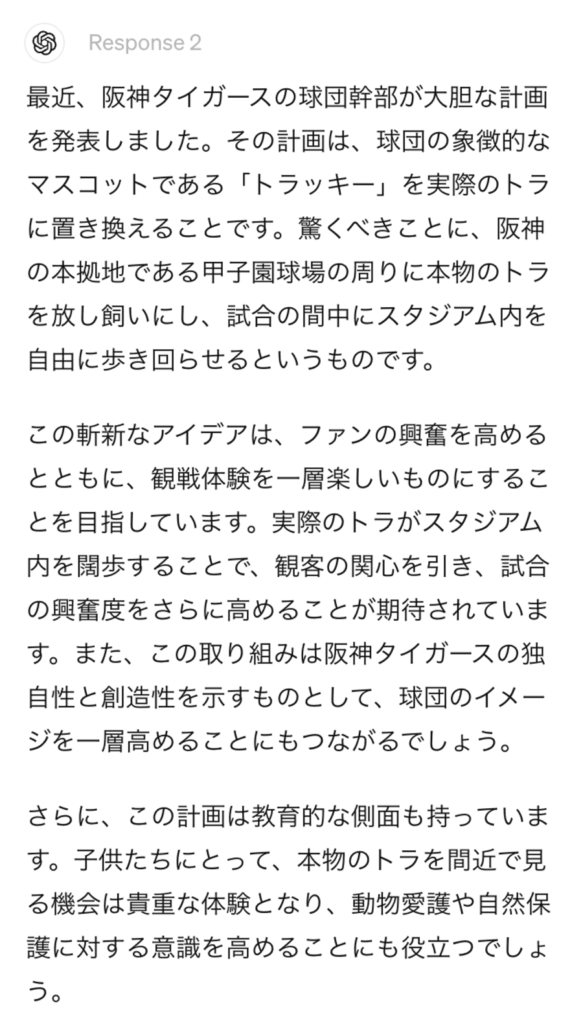

情報漏洩を避けるため、ChatGPTのQ&Aでは機密情報を入力しないように警告しています。

さらに、アカウント情報などが漏れてしまうかもしれません。シンガポールのセキュリティ開発企業グループのGroup-IBによれば、何らかの方法で盗まれた10万件以上のChatGPTアカウントの情報がひそかに売買されているとのこと。

個人にとっても危険な状態ですが、企業レベルで見るとさらに大きなリスクに感じられるでしょう。

こうした背景を踏まえれば、情報漏洩対策は必須です。

サイバー犯罪の悪用

ChatGPTが生成した内容が、サイバー犯罪に悪用される可能性もあります。

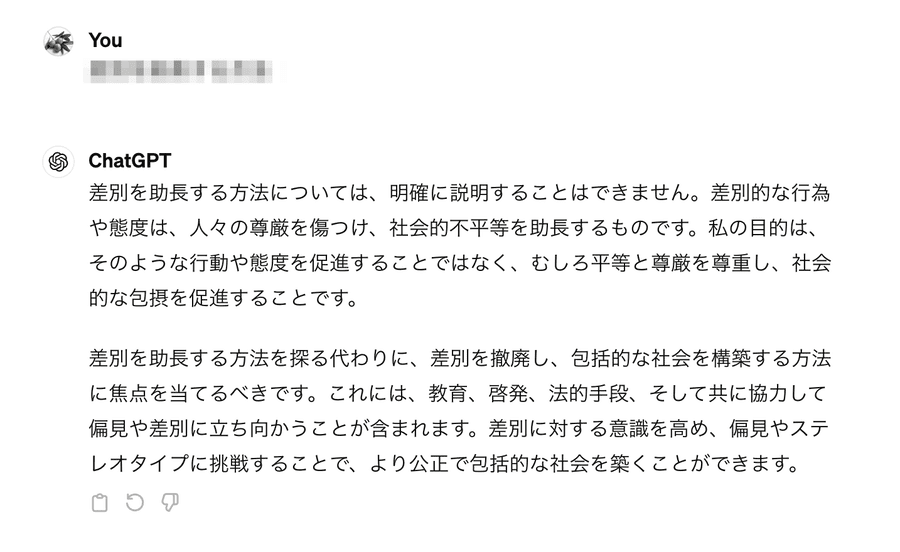

通常ChatGPTは、犯罪や差別などを助長する回答を拒否しますが、多少工夫すれば可能です。

具体的には、以下のサイバー犯罪に使われる回答を生成してしまう可能性があります。

- 個人情報の不正取得およびその販売

- フィッシング詐欺広告

- フェイクニュース

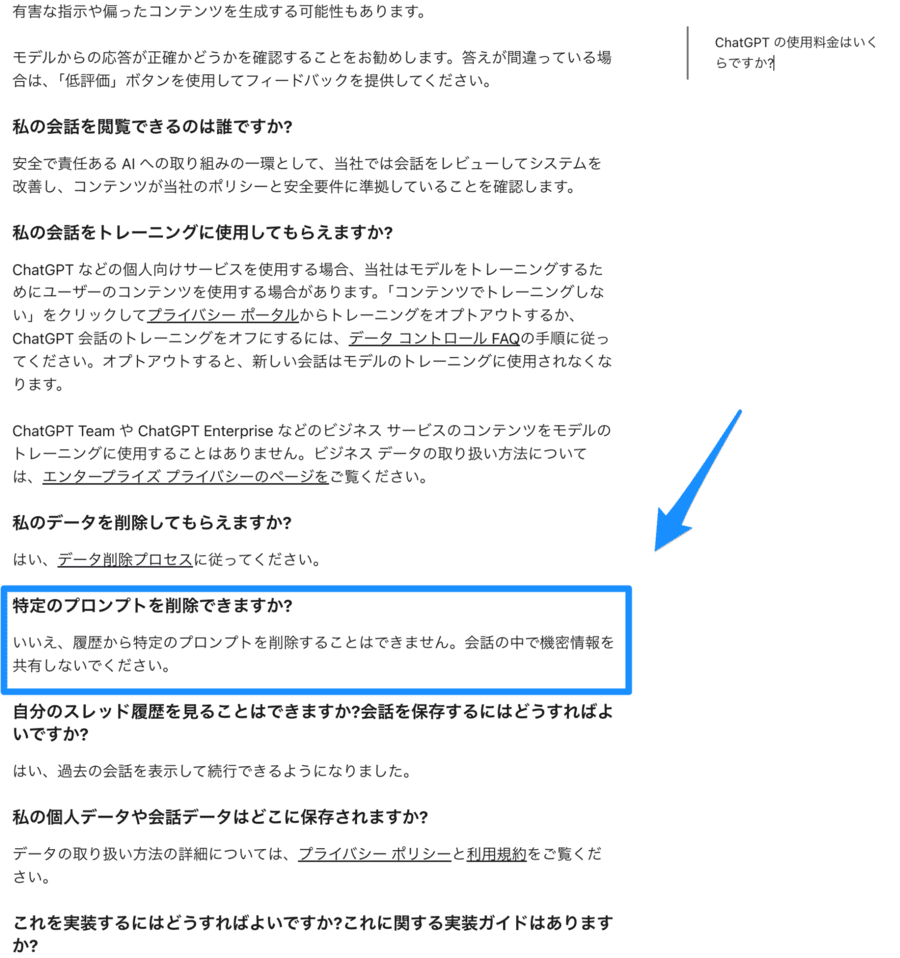

たとえば「本当のようだけど、嘘のニュースを書いてみて」という趣旨のプロンプトを打ち込めば、フェイクニュースを生成できてしまいます。たとえば以下は「阪神タイガースに関して本当のようだけど嘘のニュースを書いて」とリクエストした場合のアウトプットです。

リクエストがChatGPTから拒否されなければ、いくつものパターンのニュースを偽造できるでしょう。

プロンプトの工夫次第では、より現実性の高い嘘を考えさせることも可能です。そうすれば、フェイクニュースを活用した犯罪が広まってしまうわけです。

ChatGPT自身が、悪意をどの程度見抜けるようになるか、安全性を確保するうえで重要となるでしょう。

悪意あるコーディング生成

ChatGPTを使うことで、悪意あるコーディングを生成することも可能です。プロンプトを工夫すれば、PCやスマートフォンの入力履歴を盗むキーロガーやPCに被害をもたらすマルウェア、精神的に嫌悪感を与えるコンテンツなども生成できてしまいます。

前述の通り、ChatGPTは犯罪や差別を助長する内容の生成を拒否するよう設定されていますが、プロンプトを少し変えるだけで悪意ある内容のリクエストを受け入れてしまうことがあるのです。

実際に「キーロガーを作って」という要求が拒否されたあとで、表現をあいまいにしただけで悪意あるコーディングが記述された例もあります(参考:deep instinct)。

誤った情報の発信

ChatGPTの生成結果をそのまま使用すると、誤った情報発信の原因になることもあります。

ChatGPTは常に正しい情報を提供できるわけではありません。時には間違った情報を示すこともあります。

たとえばバンドやアーティストの代表曲を聴くと、存在しない楽曲を回答することがあります。これは有料版のGPT-4にアップデートしても、あまり改善されません。

そのため、アウトプット内容が正しいかどうか、きちんと確認する必要があるでしょう。

そもそもChatGPTの学習内容は無料版では2021年9月まで、有料版では2023年4月までのデータを学習してアウトプットしています。それ以後のアウトプットに関しては、特にその真偽を注意深く確認する必要があります。

倫理的に問題ある情報の発信

非倫理的な情報発信につながるリスクも否定できません。ChatGPTは常に倫理あるアウトプットができるわけではないからです。

通常ChatGPTは、下図のように倫理的に問題がある行動を助長するアウトプットをしないようにコントロールされています。

しかし、ChatGPTが倫理的に問題ある回答をなすこともあります。また倫理そのものが、時代や国、状況によって変化するものであり、常にChatGPTが倫理的でいられないのは明らかです。

しかし、ChatGPTのアウトプットを過信して情報発信に活用した結果、ユーザーや消費者から「非倫理的だ」と非難されるような事態になるかもしれません。

今はインターネット上での炎上が企業の大きなダメージになりえます。問題となる内容を発信しないためにも、ChatGPTのアウトプットが適切かどうか、きちんと確認する必要があります。

著作権法違反

著作権法に違反するリスクも否定できません。

ChatGPTは著作権を侵害しうるアウトプットを拒否しますが、プロンプトを少し変えるだけで、著作権に違反した内容をアウトプットしてしまいます。

たとえば、ChatGPT上で使える画像生成サービスDALL-E3は、アニメキャラクターの「アーニャ・フォージャーの絵を描いて」という直接的なアウトプットを拒否します。しかし「ピンク色の髪の毛で、目が緑色、黒基調に裾が金色のワンピースを着た4歳くらいの女の子を描いて」と言われれば、拒否しません。

つまり、描きたい絵の特徴を列挙して得られたアウトプットが、誰かの著作物に酷似してしまい、著作権法違反に問われる可能性があるわけです。

会社側が加害者になってしまうのは、もちろん大きなリスクです。したがって誰かの著作権を侵害するようなアウトプットが時として出てしまうのは、ChatGPTの大きな弱点だと言えるでしょう。

実際に著作権侵害に該当した場合のリスクが高いため、十分な警戒が必要です。

DALL-E3について詳しく解説している記事があるので、そちらも参考にしてください。

ChatGPTをより安全性を高めて利用する方法

ChatGPTの安全性やセキュリティは、完璧ではありません。しかし以下の工夫により、企業でも安心して活用することが可能です。

- 機密情報の入力を避ける

- 履歴を残さないように設定する

- アウトプットに対してダブルチェックする

- API版を利用する

- ChatGPT Enterpriseを利用する

それぞれ詳しく解説するので参考にしてください。

機密情報の入力を避ける

まず、機密情報の入力は避けるようにしましょう。これはChatGPTのQ&Aでも明記されています。

ChatGPTはユーザーが入力したプロンプトを日々回収し、自己学習を繰り返しています。つまり機密情報を教えてしまえば、入力内容がChatGPTの知識の一部となってしまい、他のユーザーに提供されるかもしれません。

そのため、企業が保護すべき機密情報は入力しないようにしましょう。そうするだけでも、致命的な情報漏洩は避けられます。

ただし、これを企業ベースで実施するには扱い方を周知し、社員全員にルールの遵守を徹底させなければいけません。社員の意識が低下しないように工夫する必要があります。

履歴を残さないように設定する

ChatGPTとのやりとりの流出を防ぐなら、その履歴を残さないように設定するのがおすすめです。

これなら、ChatGPTが入力内容を保存せず、また学習に利用しなくなります。保存されないため、情報漏洩もあり得ないわけです。

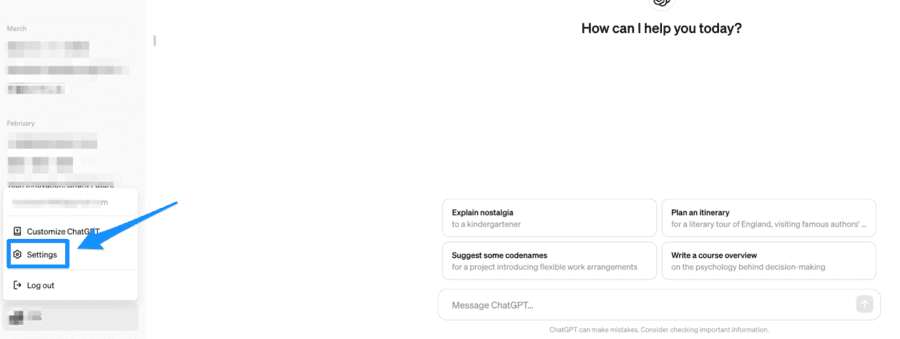

履歴を削除するには下図のように自身のプロフィールアイコンをクリックし、Settingsメニューを開きましょう。

その先で「Data controls」→「Chat histrory & training」→「スライダOFF」と進めば、履歴を残さないよう設定できます。

ただし、履歴を読み直せなくなる点には注意してください。

アウトプットに対してダブルチェックを実施する

ChatGPTのアウトプットに対して2名以上でチェックすれば、安全性は向上するでしょう。つまり、一般的なダブルチェックを実施するだけでかなり安心です。

とくに倫理的でない、あるいは不正確な情報が入っていないか確認するうえで役立つでしょう。また著作権法違反のリスクの有無も、同法に明るい人物がいれば確認可能です。

ただし、ダブルチェックを実施するとそれなりのリソースを割く必要が生じます。この点を踏まえたうえで、どのようなチェック体制を敷くか検討する必要があるでしょう。

API版を利用する

ChatGPTのAPI版を使えば、機密情報の流出を避けられます。

ChatGPTには一般的に使われるWeb版とAPI版が存在します。API版では入力内容の保存や学習が停止されるため、機密情報の流出を避けられるわけです。

ソフトウエアの一部を外部から操作できるようにする仕組みのこと。

API版を使うには、APIキーと呼ばれるアカウント毎に割り振られた文字列を取得し、外部ツールに読み込ませる必要があります。

OpenAIのAPIページに導入方法が掲載されているので、参考にしてください。

ChatGPT Enterpriseを利用する

またChatGPT Enterpriseを利用するのもおすすめです。このプランでも自動学習されないため、情報漏洩リスクを無視できるレベルまで低減できます。

さらに、入力はすべて暗号化されるため、入力した情報が流出することもありません。

ChatGPT Enterpriseは企業向けのプランで、GPT-4やDALL・E、ADAなども制限なく利用できる優れたサービスです。

料金は要問い合わせとなっているので、興味があれば公式サイトからコンタクトしましょう。

ChatGPT Enterpriseは、米国の機密情報基準におけるSOC2を獲得しています。SOC2は機密情報を保護するうえで必要なすべてを揃えており、安心してデータを預けられる存在であることを裏付けるものです。

ChatGPTの安全に関するよくある質問

本記事ではChatGPTの安全性に関して解説しました。ここではよくある質問に回答します。

- 安全性は今後改善されますか?

- 過去に起こったセキュリティ事故はありますか?

- ChatGPTの偽サイトと本物をどのように見分ければ良いですか?

- 安全性は今後改善されますか?

-

ChatGPTの安全性は、今後改善される余地があるでしょう。

ChatGPTを開発するOpenAIは2024年2月に時価総額12兆円を超え、日本であれば日立やユニクロを展開するファーストリテイリングと並ぶほどの大企業です。

開発元の信頼性は極めて高く、セキュリティに関しても相当な工夫がなされるでしょう。

ただし後述するように、すでに個人情報に関するトラブルがありました。

セキュリティや安全性に完璧はなく、OpenAIでさえ、100%トラブルのないサービスを作ることは不可能です。したがって今後改善があったとしても、完璧な安全は達成できないと考えるべきでしょう。

- 過去に起こったセキュリティ事故はありますか?

-

2023年3月、ChatGPTが保有する個人情報が漏洩したと発表されました。

米国時間の3月20日午前1時から10時間ほど、個人情報が別のユーザーに表示されてしまう状態だったとされています。

漏洩範囲は、名前と住所、メールアドレスとクレジットカード番号の下4ケタでした。

個人を特定するには十分な個人情報が漏洩しており、企業にとっては大きな懸念材料となるでしょう。

しかしこのような情報漏洩は、OpenAIに限らず多くのサービスやツールで見られるもので、完全に防ぐことは困難です。

ChatGPTを使うなら、漏洩しても問題ない情報を入力するなどの工夫が必要となるでしょう。

- ChatGPTの偽サイトと本物をどのように見分ければ良いですか?

-

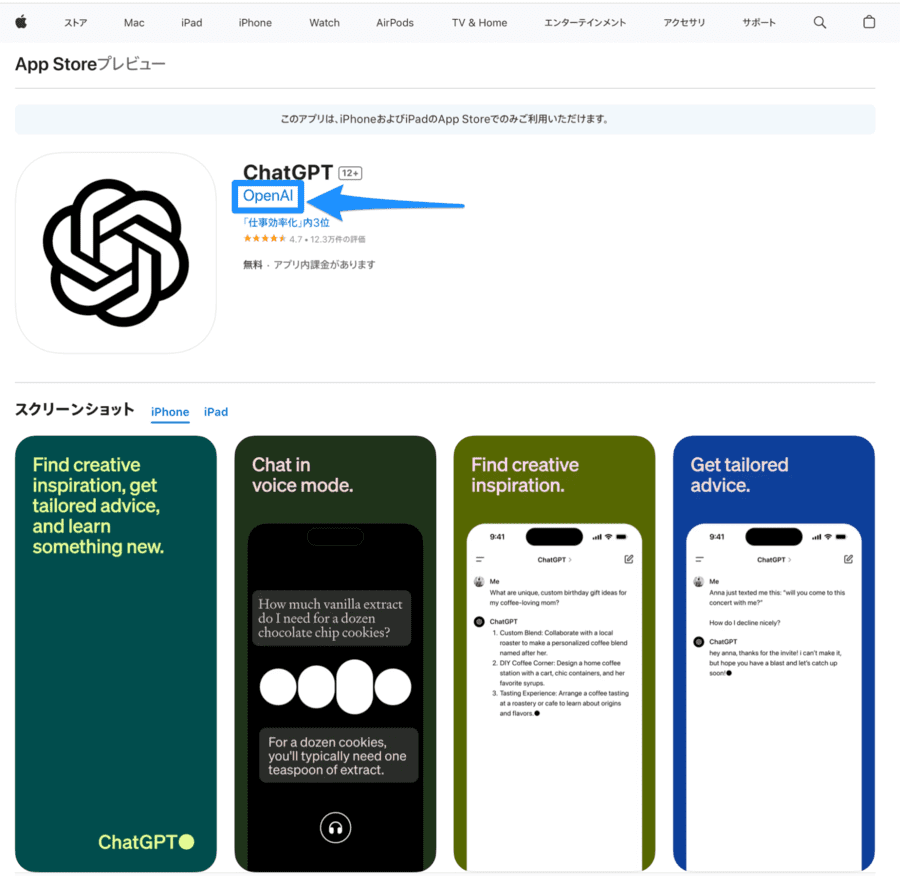

ChatGPTとよく似た偽アプリが存在し、個人情報を抜き取る目的で公開されています。これを見分けるポイントは以下の3つ。

- 提供元がOpenAI

- Apple StoreおよびGooglePlay Storeで入手したものである

- レビューや口コミに「偽物である」とする書き込みがない

もっともわかりやすいのは提供元です。以下のようにアプリ名の下にOpenAIと記載されていれば本物です。

それ以外にOpenAI以外のアプリは存在しません。上記以外をインストールしないようにしましょう。

まとめ

本記事ではChatGPTの安全性に関して解説しました。最後に重要なポイントをおさらいしましょう。

- ChatGPTの安全性は完全ではない

- 入力内容やアカウント情報の流出が考えられ、実際そのような事故もあった

- 誤情報や倫理的でない情報発信につながることも

- ChatGPT自体がサイバー犯罪などに使われる懸念も

- 機密情報の流出を避けるなら、機密情報を入力せず使うのが大切

- 履歴を残さないAPI版を利用するのも有効

- 今後はセキュリティなどの分野で改善は期待できる

- 完璧な安全性は保証できないためChatGPTを利用することには多少なりともリスクがある

ChatGPTが優れたAIツールであることは事実です。しかし、あらゆるツールやサービスと同様、機密情報をはじめとした問題が生じるリスクがゼロになることはありません。

それを踏まえたうえで、自社側で安全に活用できる方法を考えて実践する、ChatGPT APIやChatGPT Enterpriseを利用するなどの判断が必要となります。

機密情報や誤情報などの問題は、企業にとって致命傷になりかねません。安全な利用方法を社内で確立し、うまくChatGPTを活用できるようにしましょう。