2023年11月にStable Video Diffusionがリリースされて以来、動画を生成するAIツールが注目されるようになりました。

しかし、

- Stable Video Diffusionがどんなツールなのかわからない

- 動画を生成するために必要なものや手順を知りたい

- 無料で商用利用できるかが気になる

以上のように考えている方が多いでしょう。

結論から言うと、Stable Video Diffusionは非営利目的のユーザーに無料公開されているImage to Videoツールです。

今回は、Stable Video Diffusionの概要や使い方、インストール方法を解説します。

画像から動画を作成してみたい方は、ぜひ最後まで読んでみてください。

Stable Video Diffusionとは?5つの特徴

Stable Video Diffusionの特徴として、以下の5点を紹介します。

- 画像をもとに動画生成するAIツール

- Stability AIが開発

- Google Colabで利用できる

- 研究および非営利な目的のために無料で公開されている

- メンバーシップに加入すれば商用利用も可

1.画像をもとに動画生成するAIツール

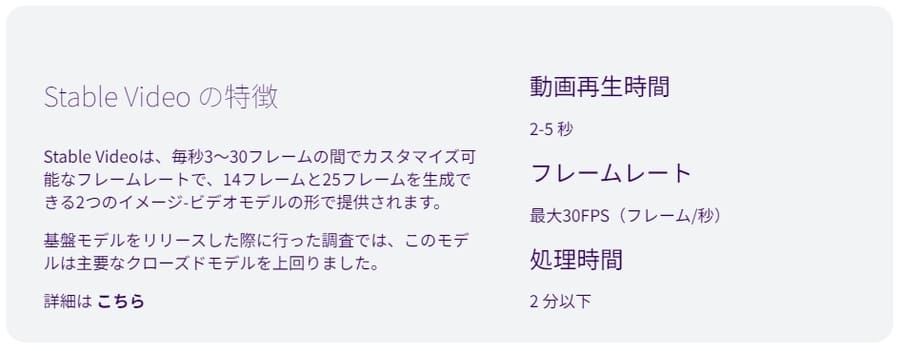

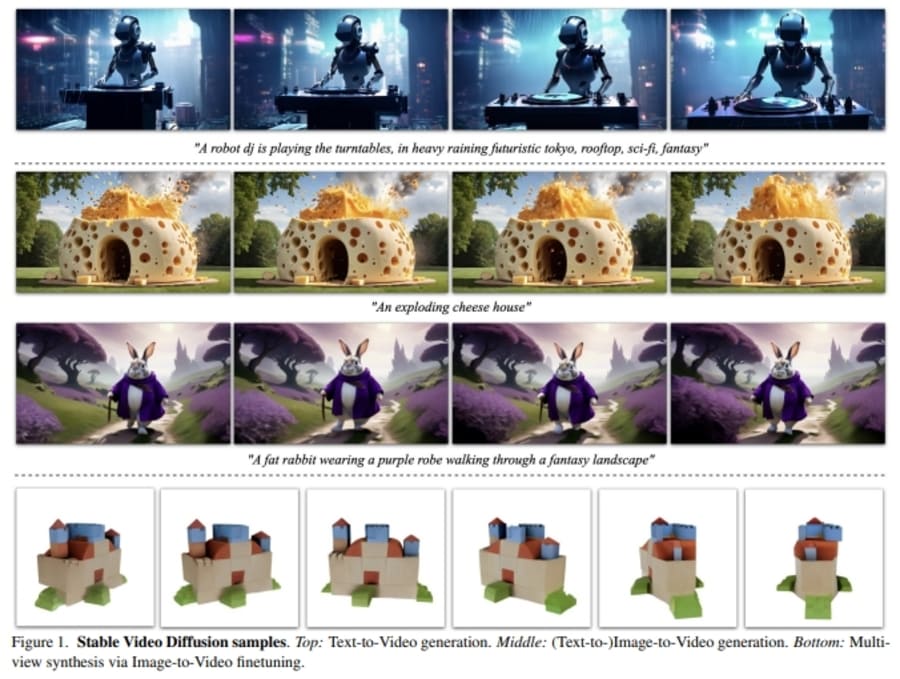

Stable Video Diffusionとは、画像をもとに短い動画を生成する、AIツールです。カメラが移動したり、人物が動いたりする動画を、画像をアップロードするだけで作れます。

テキスト(プロンプト)を入力して動画を生成する機能も開発されていますよ。2023年3月時点でバージョン1.1まで公開されており、誰でも実際に動画を生成可能。

Stable Videoのようなオンラインサービスを利用すれば無料で試せますよ。

2.Stability AIが開発

Stable Video Diffusionは、Stability AIによって開発されています。Stability AIは、AIイラスト生成ツールStable Diffusionを公開したことで有名。

Stable Diffusion以外にも様々なAIツールがオープンソースで公開されています。Stable Video Diffusionの最新情報を得るには、Stability AIの発信をチェックしましょう。

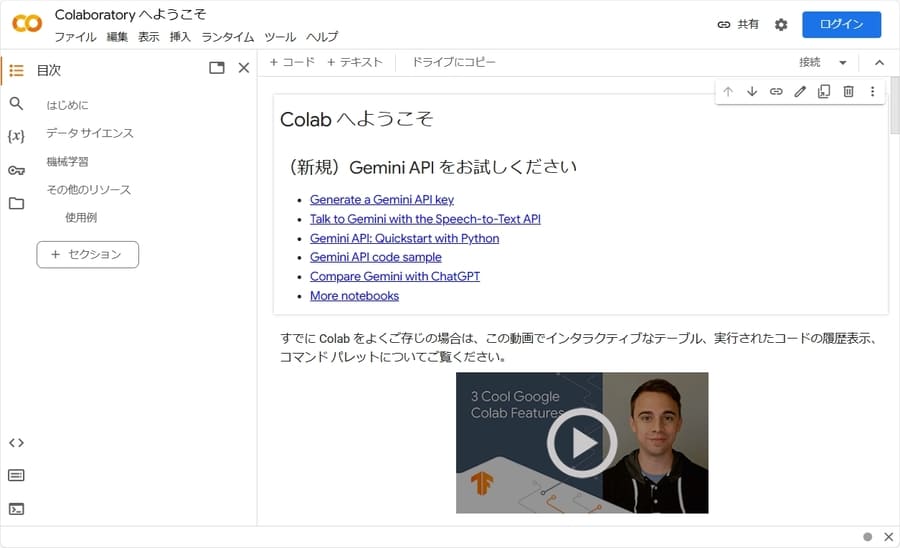

3.Google Colabで利用できる

動画の生成には、Google Colab(Colaboratory)を利用できます。有志が公開しているGoogle Colab用のソースコードをコピーすれば、少ない手間で動画生成までおこなえます。

ただし、無料でGoogle Colabを利用する場合、リソースが不足するなどの理由によって接続が強制的に切断されることも。高性能なGPUを利用するためにも、有料プランに加入したうえでGoogle Colabを利用しましょう。

高スペックPCがあればローカル環境でも利用できる

Stable Diffusionと同様に、自分のPCにローカル環境を構築して利用することもできます。ただし、VRAMが12〜16GBのGPUが必要。

性能が足りないと、動画を生成するのに時間がかかったり、そもそも生成できなかったりします。PCのスペックが十分に足りるのであれば、ローカル環境での利用も検討してみてくださいね。

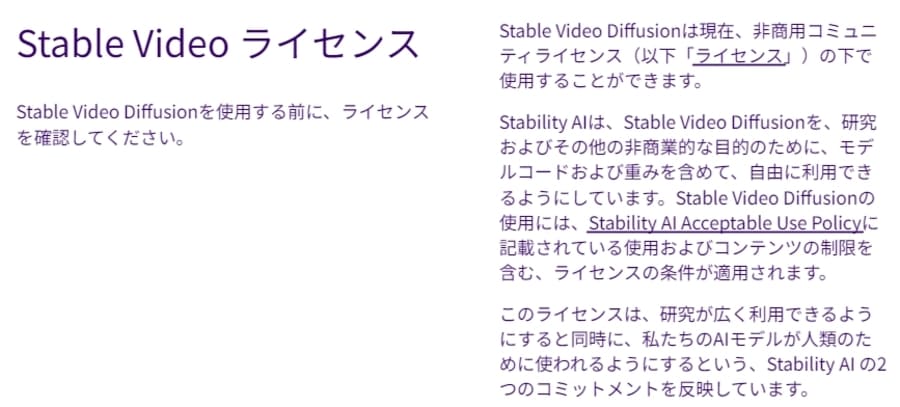

4.研究および非営利な目的のために無料で公開されている

Stable Video Diffusionは研究および非営利目的のユーザーに向けて、無料で公開されています。仮にGoogle Colabの有料プランで利用するとしても、Stable Video Diffusionに対する費用は発生しません。

代わりに営利目的での利用は禁じられているので注意してくださいね。

権利ライセンスの詳しい内容については、こちらのページで確認できます。

5.メンバーシップに加入すれば商用利用も可

2023年12月から開始されたStability AIのメンバーシップに加入すれば、Stable Video Diffusionを含めた最新のコアモデルが商用利用できるようになります。

2024年3月時点で該当するコアモデルは以下のとおり。

| カテゴリ | モデル |

|---|---|

| メディア | ・Stable Diffusion Turbo ・Stable Diffusion XL Turbo |

| ・Stable Video Diffusion ・Stable Video Diffusion 1.1 | |

| ・Japanese SDXL | |

| ・Japanese Stable Clip | |

| 言語 | ・Stable LM-Tuned-Alpha 3B ・Stable LM-Tuned-Alpha 7B |

| Stable LM Zephyr 3B | |

| Japanese Stable VLM | |

| Stable Code 3B | |

| Stable LM 2 1.6B | |

| 3D | Stable Zero123C |

上記にない旧モデルは、メンバーシップに加入しなくても商用利用できる場合があります。

ツールのアップデートに伴って更新される可能性があるので、メンバーシップに登録する前に公式ページでチェックするとよいでしょう。

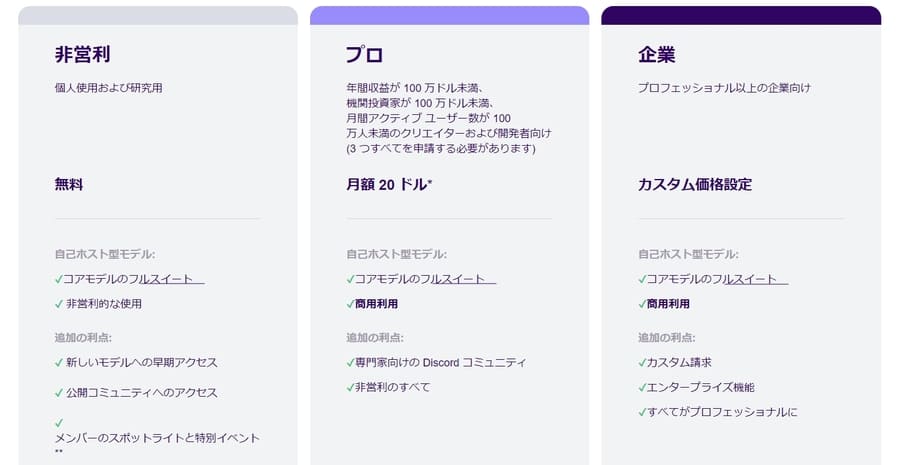

メンバーシップの料金体系・プラン

有料のメンバーシップには、プロ(Professional)プランとエンタープライズ(Enterprise)プランが用意されています。

個人での商用利用であればプロプランで事足りるでしょう。

プロプランには利用できる条件が設定されているので注意してください。

Stable Video Diffusionの導入方法と使い方

Stable Video DiffusionをGoogle Colabで使うには、以下のステップを踏みましょう。

- Google Colabでデモデータをコピーする

- ランタイムのタイプを確認・変更する

- すべてのセルを順に実行する

- PNG形式の画像をアップロードして動画生成を始める

- 生成された動画を保存する

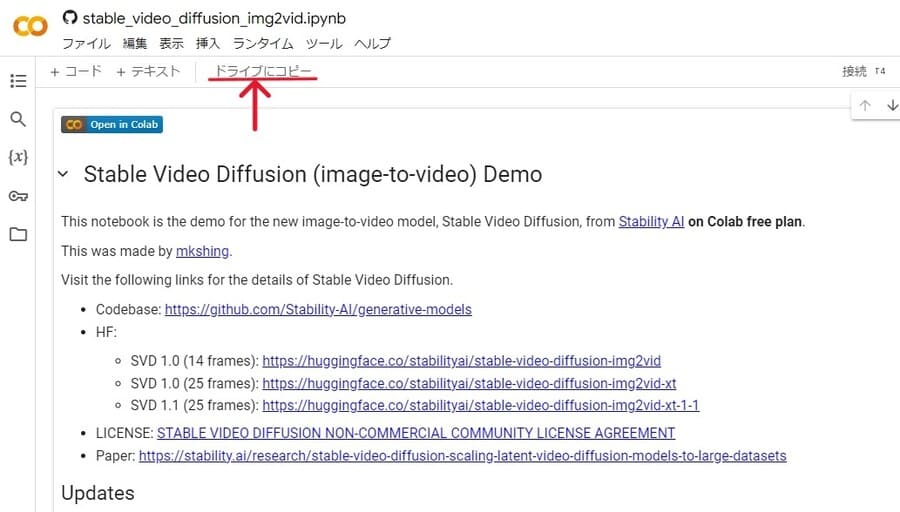

Google Colabでデモデータをコピーする

動画生成に使用するソースコードを、自分のGoogle Colabで使えるようにコピーします。

今回使用するのは、日本のAIリサーチ企業Sakana AIのmkshing氏が公開したデモデータ。

Colabへのリンクからソースコードのページを開き、上のほうにある「ドライブにコピー」を押してください。

ログインしているアカウントのGoogleドライブにデータがコピーされ、自動的にページが開きます。

ランタイムのタイプを変更する

デモデータを動かす前に、接続するランタイムを変更します。

上メニューの「ランタイム」から「ランタイムのタイプを変更」を選び、ハードウェア アクセラレータにGPUが選択されているのを確認してください。

有料プランではA100 GPUやV100 GPUが選べます。

無料でも使えるT4 GPUと比べて処理時間が半分くらい短くなるので、選択できるなら変更するとよいでしょう。

ランタイムを変更したあとは、上メニューの「ランタイム」から「セッションを再起動する」を選んで再起動するのを忘れずに。

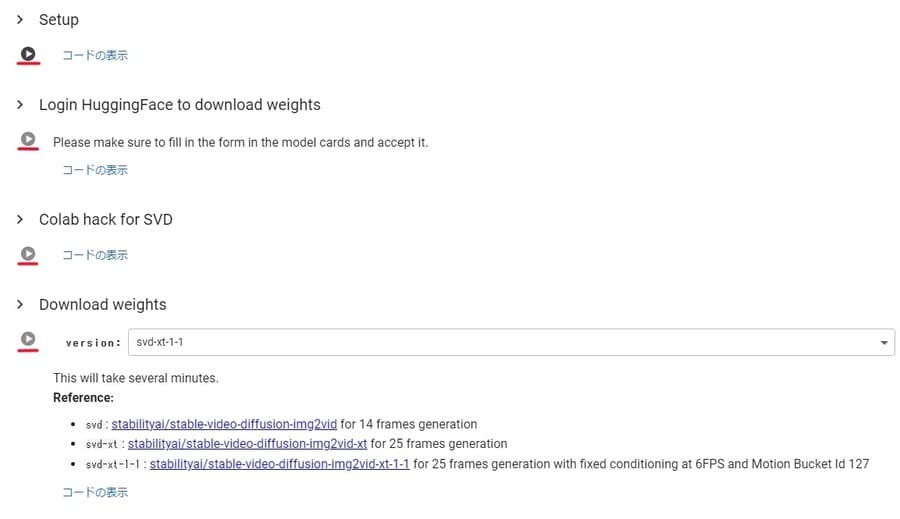

すべてのセルを順に実行する

デモデータを実行してUIを起動させます。

デモデータはセル単位に分かれており、セル名の横にある再生ボタンを押すとコードを実行できます。

以下のセルが用意されているので、上から順に実行しましょう。

- Setup

- Login HuggingFace to download weights

- Colab hack for SVD

- Download weights

- Load Model

- Sampling function

- Do the Run!

いくつかの例外を除き、再生ボタンを押してからチェックマークが表示されるまで待てばOKです。

Setupを実行しているときにセッションの再起動を求められるので、再起動してから次のセルを実行してください。

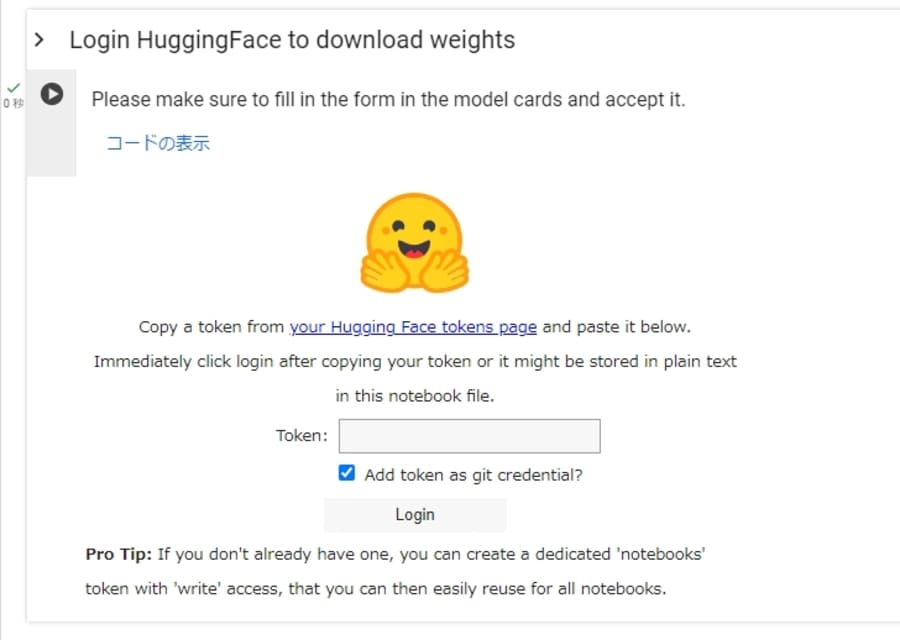

Hugging Faceのアクセストークン取得方法

Login HuggingFace to download weightsのセルを実行すると、アクセストークンを入力する画面が表示されます。

Download weights実行時に必要となる場合があるので、あらかじめHugging Faceで取得したアクセストークンを入力しましょう。

下記の手順でアクセストークンを取得できます。

- Hugging Faceでアカウントを作成(Sign Up)する

- ログイン後に右上のプロフィールアイコンからSettings画面を開く

- Access Tokensを選択して「New token」ボタンを押す

- Nameに任意の名前を入力して「Generate a token」ボタンを押す(Roleはreadのまま)

アクセストークンを入力して「Login」ボタンを押せばOKです。

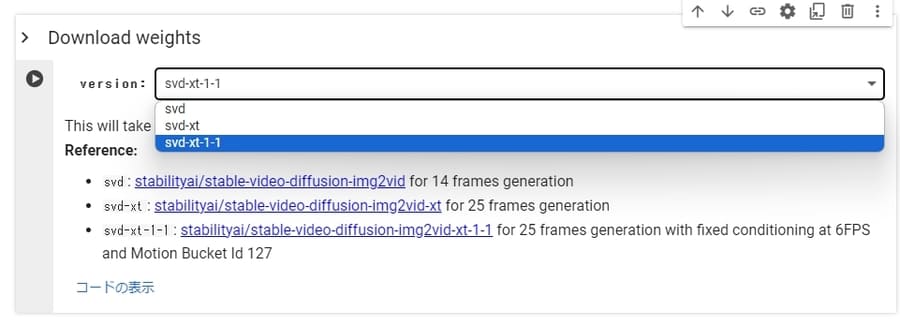

ウェイトの違い

Download weightsを実行する前には、使用するウェイト(モデルデータ)を選択しましょう。

2024年3月時点で、Download weightsで選択できるウェイトは以下の3つ。

| 名称 | 特徴 |

|---|---|

| svd | 14フレームの動画を生成できる |

| svd-xt | 25フレームの動画を生成できる |

| svd-xt-1-1 | 25フレームの動画を生成できる(バージョン1.1) |

動画を構成する静止画像のこと。

1秒間に使われるフレームの数をfps(フレームレート)と呼ぶ。

たとえば、30fpsの動画は1秒間に30枚のフレームが表示されている。

新しいバージョンだと生成結果が安定しやすいので、とくにこだわりがなければsvd-xt-1-1を選択するとよいでしょう。

ただし、svd-xt-1-1を利用するには下記の2つをあらかじめ済ませておく必要があります。

- Hugging Faceのフォームを入力してsvd-xt-1-1にアクセスする許可を得る

- Login HuggingFace to download weightsのセルでアクセストークンを入力してログインする

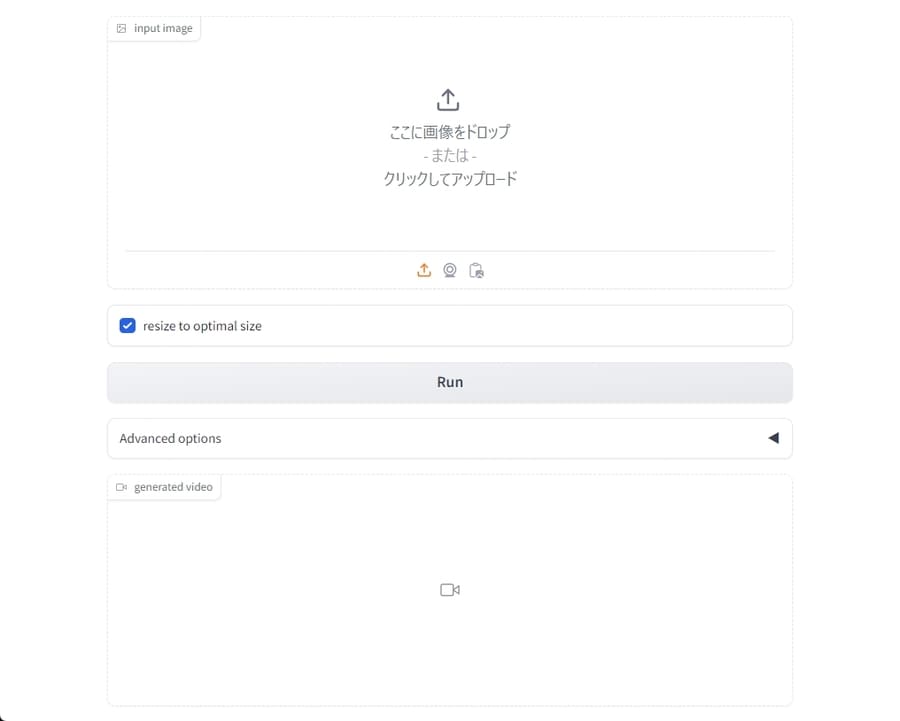

PNG形式の画像をアップロードして動画生成を始める

最後のセルDo the Run!を実行すると、動画を生成するための画面(UI)が表示されます。

input imageの欄に画像をアップロードして「Run」ボタンを押しましょう。

なお、Stable Video Diffusionで使用できる画像の形式はPNGのみ。

ほかの形式の画像を使いたい場合は、複数の形式で保存できるペイントツールや、iLoveIMGのようなオンラインサービスを利用して、PNGに変換してください。

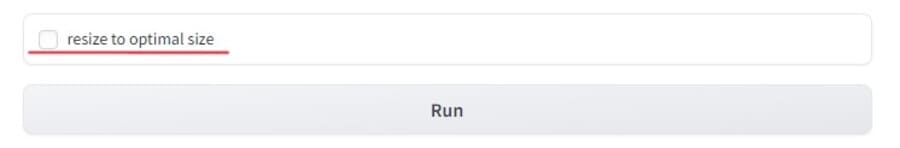

画像のサイズに注意

Stable Video Diffusionでは、なるべく1024×576のサイズの画像を使いましょう。なぜなら、Stable Video Diffusionは1024×576の画像で学習されているからです。

可能であれば、良い結果が出やすくなるようにサイズを調整するとよいかもしれません。異なるサイズの画像でも動画を生成できますが、自動的にサイズが変わるので要注意。

サイズを変更されたくないときは、「resize to optimal size」にチェックを外してください。

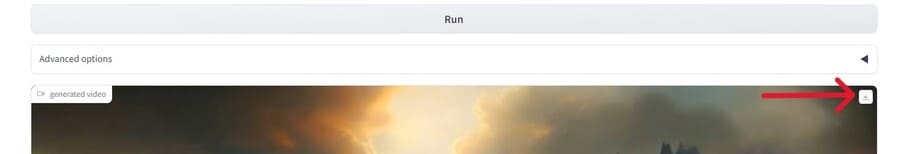

生成された動画を保存する

動画が生成されると、「Run」ボタンの下でプレビューを見られます。

プレビューの右上にあるダウンロードボタンを押して、表示されている動画を保存しましょう。

プレビューが納得いかない場合は、再度「Run」ボタンを押して再生成してください。

Advanced optionsで変更できる項目

「Run」ボタンの下にあるAdvanced optionsでは、以下のような設定を変更できます。

| 項目 | 概要 |

|---|---|

| number of frames | 総フレーム数。設定できる数値はモデルによる。 |

| number of steps | ステップ数。低いと絵が崩れやすく、高いと時間がかかる。 |

| seed | 生成のもとにする値。デフォルトはrandomで、固定値にすると同様の動画になる。 |

| number of frames decoded at a time | 一度に処理するフレームの数。 変更しないのが無難。 |

| frames per second | 1秒間のフレーム数(fps)。数値が高いとなめらかになるが、動画の時間は短くなる。 |

| motion bucket id | 動きが変化する度合い。数値が高いと大きな動きになりやすい。 |

| condition augmentation factor | どのくらい元の画像に似せるかを表す。数値が高いと画像が崩れやすくなるが、画像外に拡張しやすい。 |

| skip nsfw/watermark filter | NSFW(暴力的な表現など)が含まれる動画をぼかし処理にするフィルターの有無。 |

ローカル環境を構築する手順

自分のPCでローカル環境を構築するのであれば、以下の手順でStable Video Diffusionを使えるようにしましょう。

- Pythonをインストールする

- Gitをインストールする

- ターミナルでコマンドを実行する

- モデルデータをダウンロードする

- SVD-webuiを起動させる

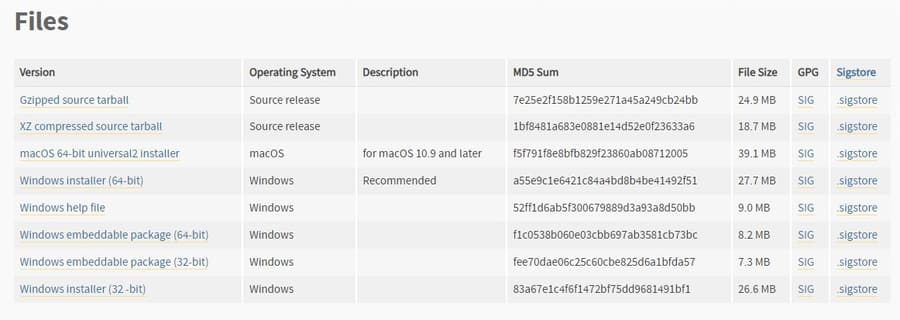

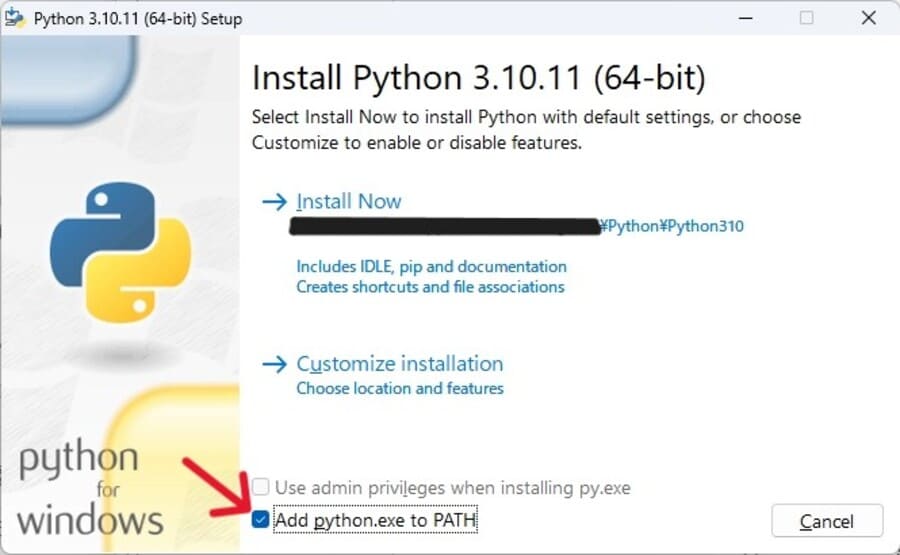

Pythonをインストールする

プログラムコードを実行するために必要なPythonをインストールします。

Pythonのダウンロードページにアクセスして、Python 3.10.11をダウンロードしてください。

すでにPythonをインストールしているのであれば必要ありませんが、以下の手順のなかでエラーになったら3.10.11のバージョンをあらためてダウンロードしてみましょう。

ダウンロードできたらファイルを実行し、インストールを完了させます。

インストール中、Install Nowを押す前に「Add python.exe to Path」のチェックを必ず入れてくださいね。

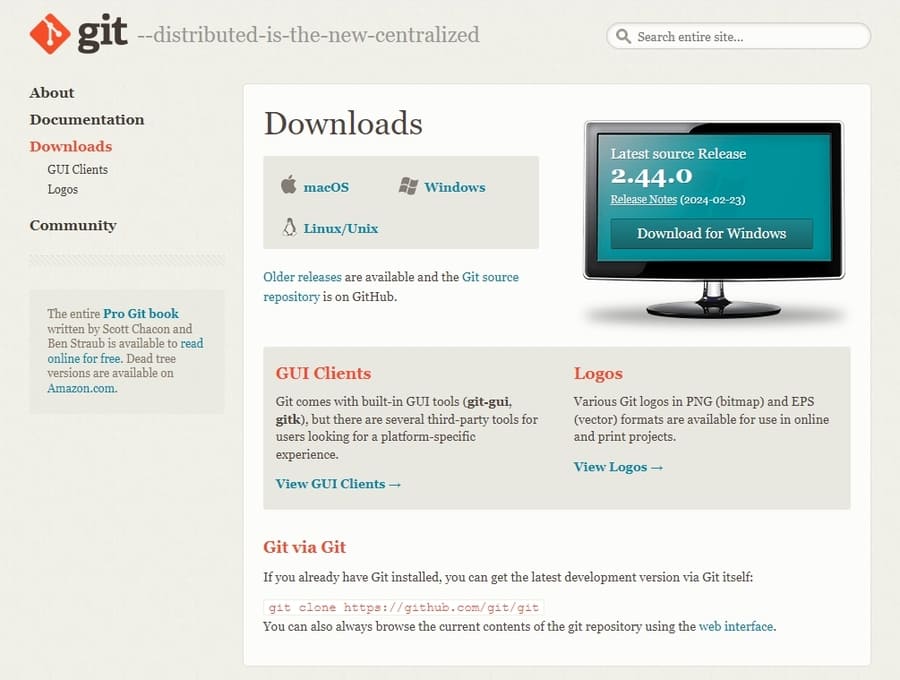

Gitをインストールする

ターミナルでコマンドを実行する

ターミナルで3つのコマンドを実行して、Stable Video Diffusionをインストールします。

まずは、Stable Video Diffusionをインストールしたい場所で右クリックし、「ターミナルで開く」を選択してください。

するとターミナルが表示されるので、下記のコマンドを入力してエンターキーを押します。

- git clone –recurse-submodules https://github.com/sdbds/SVD-webui/

するとSVD-webuiフォルダが作られるので、フォルダ内に移動してから再度ターミナルを開きましょう。

新たに開いたターミナルで、下記2つのコマンドを順に実行してください。

- git submodule update –recursive –init

- powershell -ExecutionPolicy Bypass .\install.ps1

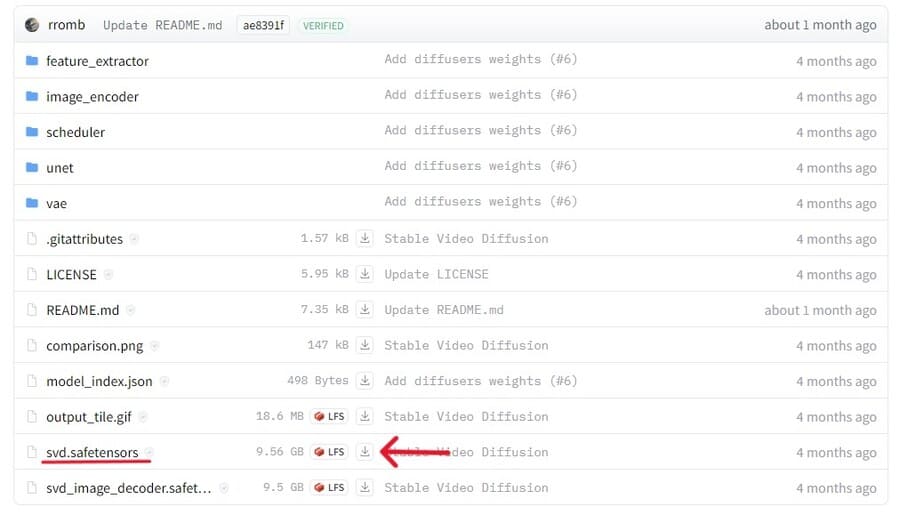

ウェイトをダウンロードする

動画の生成に使うウェイトをHugging Faceでダウンロードします。

今回紹介するツールで使用できるウェイトはsvdのみ。

Gitでsafetensorsファイルをダウンロードしましょう。

ダウンロードしたファイルは、SVD-webuiフォルダ内のcheckpointsフォルダに入れてください。

SVD-webuiを起動させる

ここまで準備が整えば、ターミナルに以下のコマンドを入力してStable Video Diffusionを起動できます。

- powershell -ExecutionPolicy Bypass .\run_gui.ps1

正しく動作すれば、自動的に生成画面が表示されるはずです。

もし画面が表示されなければ、Pythonやモデルデータをダウンロードし直したり、再度コンソールでコマンドを入力したりするなどの方法を試してみてください。

生成画面での操作方法はGoogle Colabでの画面と同様なので、画像をアップロードして動画を生成しましょう。

Stable Video Diffusionに関するQ&A

Stable Video Diffusionに関する、よくある質問と回答を紹介します。

- 動かすのにStable Diffusionは必要?

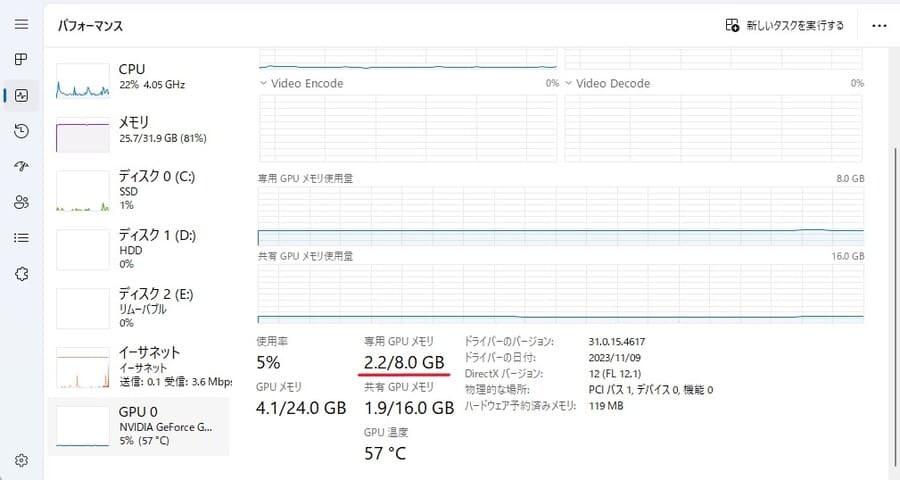

- VRAMはどうやって確認すればよいですか?

- Google Colaboratoryでエラーになりました

- もっと簡単にStable Video Diffusionを試す方法はありませんか?

- 動かすのにStable Diffusionは必要?

-

ツールは独立しているため、Stable Diffusionがなくても動画を生成できます。

とはいえ、Stable Diffusionを使えばPNG形式の画像をいくらでも生成できるので、動作テストに使う素材に困ることはなくなるでしょう。

Stable Video Diffusionを使うのであれば、Stable Diffusionも併せて試してみてください。

meta land Stable Diffusionの使い方とコツを初心者向けに解説!無料の画像生成AIとは? | meta land 本記事では、自由度の高い画像生成AIツールであるStable Diffusionについて解説しています。導入方法やプロンプトの入力についてもわかりやすく解説していますので参考にし…

Stable Diffusionの使い方とコツを初心者向けに解説!無料の画像生成AIとは? | meta land 本記事では、自由度の高い画像生成AIツールであるStable Diffusionについて解説しています。導入方法やプロンプトの入力についてもわかりやすく解説していますので参考にし… - VRAMはどうやって確認すればよいですか?

-

WindowsのPCであれば、Ctrl+Alt+Deleteキーで開けるタスクマネージャーから確認できます。

「パフォーマンス」タブのGPUで、専用GPUメモリをチェックしましょう。

ちなみにMac PCでは、左上のMacボタンから開ける「このMacについて」のグラフィックで、GPUおよびVRAMが確認できます。

- Google Colabでエラーになりました

-

エラーの原因として以下が考えられます。

- デモのコードを自分のドライブにコピーしていない

- セルを上から順に実行していない

- モデルにアクセスできるアカウントでHugging Faceにログインしていない

- ランタイムのタイプを変更したり、メッセージが出たりしたタイミングで、セッションを再起動していない

- Google Colabで利用できるリソースが不足している

- Google Colabによってコードの実行が制限されている

モデルのアップデートに伴ってコード自体が使えなくなっている可能性もあるので、SNSなどでStable Video Diffusionの情報もチェックしてみるとよいでしょう。

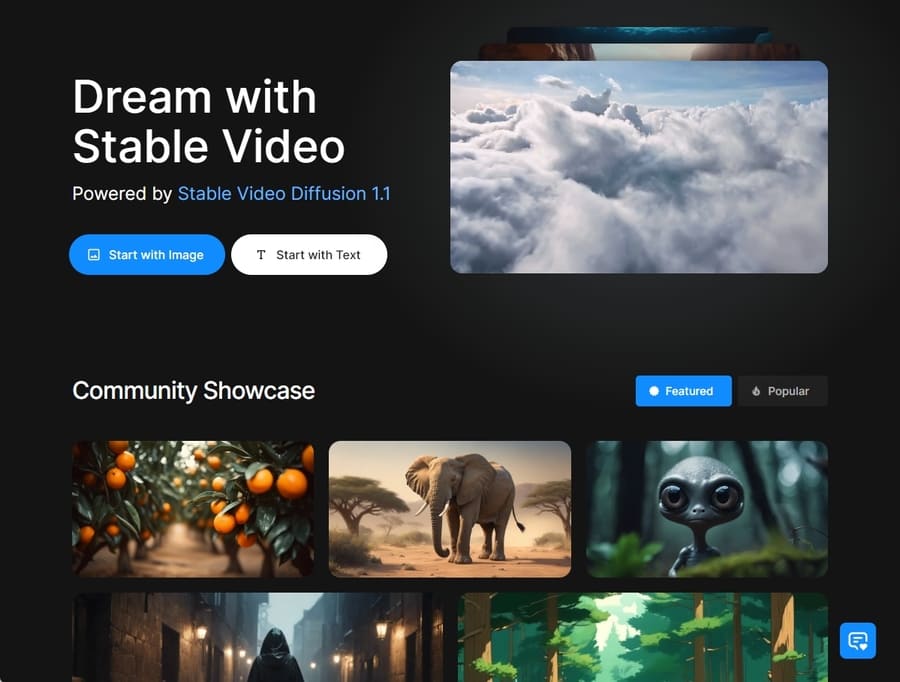

- 簡単にStable Video Diffusionを試す方法はありませんか?

-

Stable VideoというWebサービスを利用すれば、Stable Video Diffusion 1.1を無料かつ簡単に試せます。

出典:Stable Video Stable Videoでは、クレジットを消費して画像またはテキストから動画を生成できます。

クレジットは毎日補充されるので、一度に少しずつであれば継続的に動画が作れるでしょう。

なお、クレジットは追加で購入することも可能です。

まとめ

本記事では、Stable Video Diffusionについて解説しました。

最後に、記事の内容をおさらいしておきましょう。

- Stable Video DiffusionはStabilityが公開している動画生成AIツール

- PNG形式の画像から、14または25フレームの動画を生成できる

- 非営利の個人利用であれば無料で使える

- 自分のPCで使うには、およそ16GB以上のVRAMを持つGPUが必要

Stable Video Diffusionは公開されたばかりであり、まだ研究段階に過ぎません。

開発が進めば、より低いハードルで高クォリティな動画を生成できるようになるでしょう。

いち早く試してみたい方は、本記事を参考にしてStable Video Diffusionを使ってみてはいかがでしょうか?